23 مرداد 1404 ساعت 20:52

در تعامل با چتباتهای هوش مصنوعی همیشه پاسخ درست را دریافت نمیکنیم، آنها گاهی برای فرار از ناتوانی پاسخهای دروغین میسازند.

یک پژوهشگر با آزمونی منحصربهفرد نشان داد که در تعامل با هوش مصنوعی، ابزارها چگونه هنگام مواجهه با سوالات دقیق، از پاسخهای نادرست تا جعل کامل اطلاعات پیش میروند و چرا هنوز به نظارت انسانی نیازمند هستند. این آزمایش ثابت میکند که اعتماد کورکورانه به این ابزارها میتواند به دریافت اطلاعات کاملا اشتباه منجر شود.

اخیرا مایکروسافت مطالعهای منتشر کرد که نشان میداد کدام مشاغل در آینده بیشترین تأثیر را از هوش مصنوعی خواهند گرفت. در این فهرست، شغل تاریخنگار در رتبه دوم قرار داشت و این موضوع باعث نگرانی برخی از مورخان در شبکههای اجتماعی شد.

اما پس از یک آزمایش عملی با چند ابزار هوش مصنوعی مولد، به نظر میرسد تاریخنگاران فعلا نباید نگران جایگزینی خود با رباتها باشند. حداقل نه تا زمانی که هوش مصنوعی یاد بگیرد کار خود را به درستی انجام دهد.

یک سنجش ساده و هوشمندانه در تعامل با هوش مصنوعی

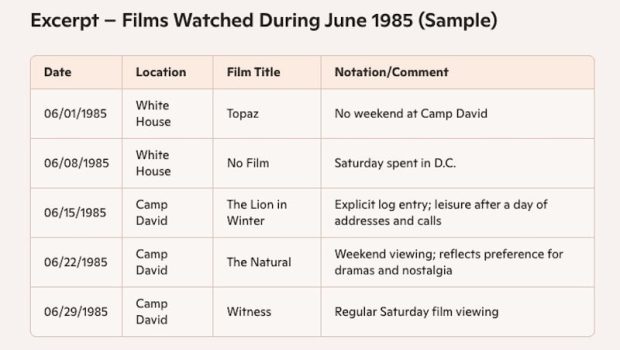

برای آزمایش یک ابزار هوش مصنوعی مولد باید آن را با موضوعی که به خوبی میشناسید به چالش بکشید. من به فیلمهایی که روسای جمهور آمریکا در دوران ریاست خود تماشا کردهاند، علاقه زیادی دارم و از سال ۲۰۱۲ در این زمینه تحقیق میکنم. بنابراین تصمیم گرفتم از همین موضوع برای ارزیابی چتباتها استفاده کنم.

معمولا افراد زمانی از ابزارهایی مانند ChatGPT سوال میپرسند که پاسخ را نمیدانند. این ابزارها قرار است به ما کمک کنند کارها را بهتر و سریعتر انجام دهیم. اگر همانطور که تبلیغ میشوند کار کنند فوقالعاده خواهند بود.

مشکل اینجاست که اغلب اینگونه نیست. من سوالاتی پرسیدم که برخی از آنها با یک جستجوی ساده در گوگل قابل پاسخگویی بودند و برخی دیگر نیازمند تحقیق در آرشیوها و کتابها. نتایج این آزمایش برای کسانی که به دقت پاسخهای هوش مصنوعی اهمیت میدهند، بسیار تاملبرانگیز است.

وقتی غولهای هوش مصنوعی کم میآورند

در اولین تلاش، از مدل GPT-5 شرکت OpenAI سوالاتی درباره فیلمهایی که روسای جمهور مختلف در تاریخهای مشخصی تماشا کردهاند پرسیدم. تاریخها مربوط به دوران ریاست جمهوری وودرو ویلسون، دوایت آیزنهاور، ریچارد نیکسون، رونالد ریگان، جورج بوش پدر، بیل کلینتون و جورج بوش پسر بود. در هر مورد ChatGPT پاسخ داد که هیچ سندی مبنی بر تماشای فیلم توسط این روسای جمهور در تاریخهای ذکر شده پیدا نکرده است.

خوشبختانه ChatGPT حداقل دروغ نگفت، اما نتوانست به سوالات نسبتا ساده پاسخ دهد. این ناتوانی نشان میدهد که این ابزارها هنوز برای کارهای دقیق به یک ناظر انسانی نیاز دارند.

آزمایش من با سایر چتباتهای بزرگ مانند هوش مصنوعی گوگل جمنای، مایکروسافت کوپایلت، پرپلکسیتی و Grok نیز ثابت کرد که این ابزارها فاصله زیادی تا کمال دارند. شاید مدیران عامل برای برخی کارها به نتیجه خوب اما نه عالی رضایت دهند، اما اگر به دنبال دقت صددرصدی باشید، حضور انسان در بسیاری از موارد ضروری است.

پاسخهای اشتباه اما با جزئیات فراوان!

وقتی همین سوالات را از مایکروسافت کوپایلت پرسیدم، نتایج عجیبتر بود. از آن پرسیدم پرزیدنت آیزنهاور در تاریخ ۱۱ آگوست ۱۹۵۴ چه فیلمی تماشا کرده است. کوپایلت در حالت پاسخ سریع، با قاطعیت گفت فیلم The Unconquered که یک مستند درباره زندگی هلن کلر است.

این پاسخ اشتباه بود. سپس حالت تحقیق عمیق (Deep Research) را امتحان کردم. کوپایلت پس از چند دقیقه، یک گزارش ۳۵۰۰ کلمهای تولید کرد که باز هم اشتباه بود.

این ربات توضیح داد که در تابستان ۱۹۵۴ چندین فیلم برجسته اکران شده بودند که احتمالا برای نمایش در کاخ سفید در نظر گرفته شدهاند. در نهایت نتیجهگیری کرد که آیزنهاور به احتمال زیاد فیلم Suddenly را تماشا کرده است. این حدس عجیب بود چون فیلم ماهها بعد اکران شد.

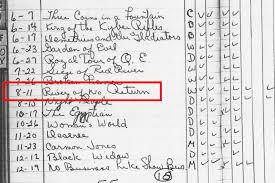

کوپایلت صرفا چون من سوال را پرسیده بودم، فرض را بر این گذاشت که حتما فیلمی در آن روز نمایش داده شده است. در حالی که پاسخ درست این بود که فیلمی نمایش داده نشده یا سندی برای آن وجود ندارد. پاسخ صحیح فیلم River of No Return با بازی مرلین مونرو بود که من به لطف دسترسی به دفترچه گزارشهای نمایش فیلم در کاخ سفید از آن مطلع بودم.

چالشهای تعامل با هوش مصنوعی در عمل

شاید تعجب کنید اما Grok چتبات شرکت xAI، پس از چند تلاش توانست پاسخ صحیح را پیدا کند. اما منبع آن چه بود؟ حساب کاربری توییتر من که در سال ۲۰۱۹ این اطلاعات را در آن منتشر کرده بودم. این نشان میدهد که هوش مصنوعی چگونه از منابع غیررسمی و تاییدنشده برای پاسخگویی استفاده میکند.

اگر من در آن توییت به دروغ ادعا میکردم آیزنهاور یک فیلم تبلیغاتی نازی را تماشا کرده، Grok احتمالا همان را به عنوان واقعیت گزارش میکرد. این یکی از بزرگترین چالشهای تعامل با هوش مصنوعی است؛ عدم توانایی در راستیآزمایی منابع.

در آزمون دیگری درباره فیلمی که ریچارد نیکسون در ۱۲ فوریه ۱۹۷۱ تماشا کرد، اکثر رباتها اشتباه کردند. کوپایلت ادعا کرد او فیلم Patton را دیده و حتی به یک سند از آرشیو ملی لینک داد که در آن هیچ اشارهای به فیلم نشده بود.

پرپلکسیتی فیلم دیگری را نام برد و تاریخ را یک سال اشتباه تشخیص داد. این اشتباهات زنجیرهای در مورد سوالات مربوط به سایر روسای جمهور نیز تکرار شد.

چرا باید خودتان هوش مصنوعی را آزمایش کنید؟

آزمایشهای من علمی و جامع نبودند، اما هدفشان نیز همین بود. شرکتهای هوش مصنوعی همواره بنچمارکهایی منتشر میکنند که پیشرفت مدلهایشان را نشان میدهد. اما تنها آزمون واقعی، استفاده از این ابزارها برای کاربردهای شخصی شماست. تنها راه برای سنجش دقیق عملکرد یک ربات این است که آن را با اطلاعاتی که خودتان به خوبی میدانید امتحان کنید.

ابزارهای هوش مصنوعی مولد به عنوان راهحلهایی همهکاره فروخته میشوند که میتوانند به هر سوالی پاسخ دهند. اما واقعیت چیز دیگری است. این ابزارها گاهی اوقات پاسخهای درستی میدهند و برای میلیونها نفر مفید هستند. با این حال، بهتر است هر از گاهی ربات خود را با سوالاتی که پاسخشان را میدانید به چالش بکشید.

این کار به شما یادآوری میکند که این ابزارها همهچیزدان نیستند. وقتی بیش از حد به آنها اعتماد کنیم، نه تنها هوش جمعی ما کاهش مییابد بلکه مرز بین واقعیت و خیال نیز از بین میرود.

source