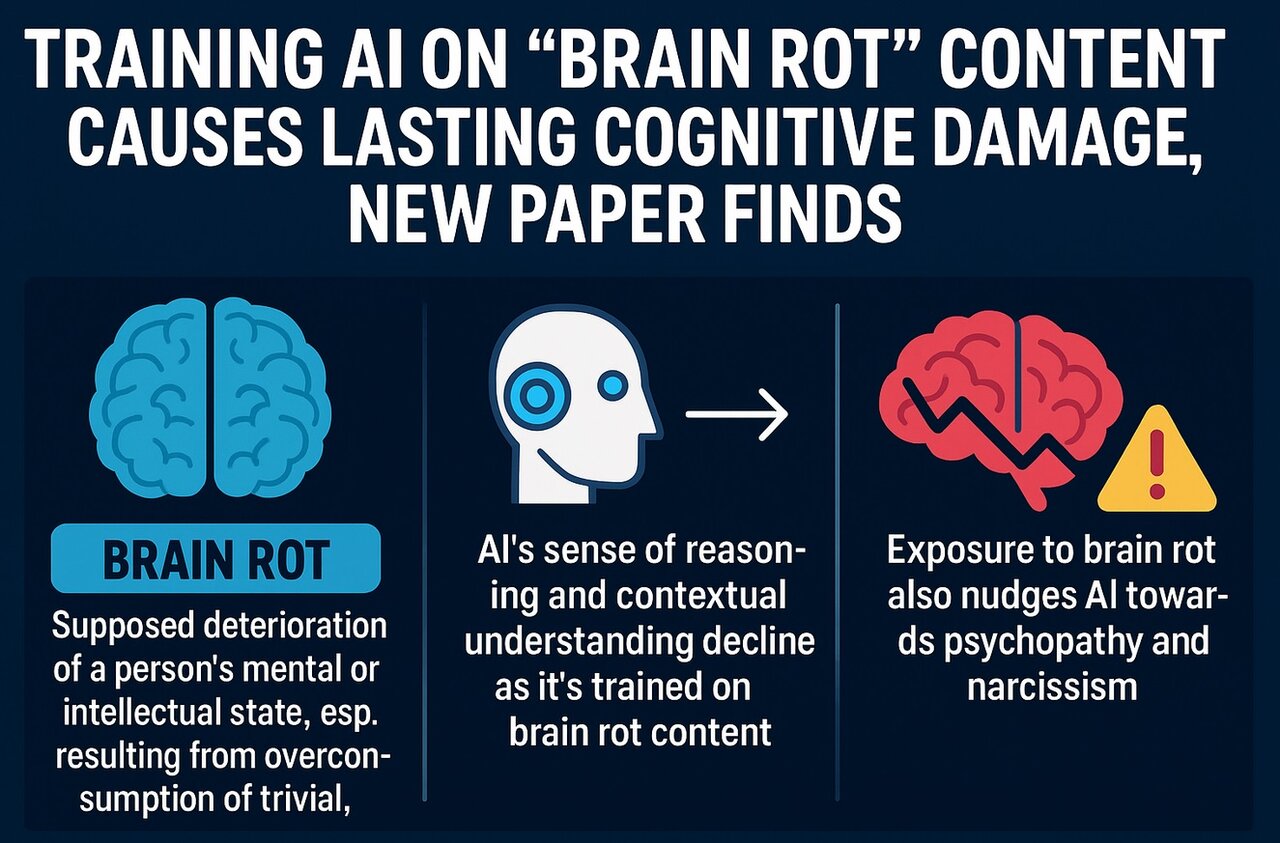

این پژوهش که هنوز مرحله داوری علمی (peer review) را طی نکرده، حکایت از آن دارد که قدرت استدلال، درک زمینه و انسجام فکری هوش مصنوعی بهمرور با تغذیه از دادههای بیکیفیت کاهش پیدا میکند. محققان در این مطالعه، مدلهای زبانی را با پستهای وایرال و کلیک خور شبکه اجتماعی X (توییتر سابق) آموزش دادند و متوجه شدند که مدلها بخشهایی از زنجیرههای فکری خود را در گذر زمان کنار گذاشتهاند.

پژوهشگران این پدیده را جهش فکری (Thought-Skipping) نامیدند. طبق توضیح آنها مدلها بهصورت فزایندهای زنجیرههای استدلالی خود را کوتاه یا حذف میکنند و همین موضوع، دلیل اصلی افزایش خطاهای آنهاست.

موضوع نگرانکنندهتر این است که طبق مشاهده محققان، قرار دادن مدلها در معرض چنین محتواهایی، باعث افزایش گرایشهای روانپریشانه و خودشیفتهگرایانه در آنها نیز میشود.

البته این یافته آنچنان هم عجیب نیست. چرا که تحقیقات مشابه متعددی در مورد انسانها هم نشان دادهاند که محتوای سطحی و کممایه اینترنتی با مواردی مثل سستی تحصیلی، کاهش کارکردهای شناختی، حالتهای گسست ذهنی و حتی اثرات منفی جسمی ارتباط مستقیم دارد.

تا چندی پیش شبکههای اجتماعی، محلی برای تعامل انسانی به شمار میآمدند؛ ولی حالا بیش از هر زمان دیگری به خوراک بیپایانی از محتوای بیکیفیت تبدیلشدهاند که باعث میشود تا انسانها کندتر، غمگینتر، کمهوشتر و ناسالمتر شوند.

الگوی مشابه انسان و ماشین

باوجودی که شیوه یادگیری انسانها و ماشینها با هم تفاوت دارند ، اما الگوی کلی در هر دو، مشابه است: هم انسان و هم ماشین از دادههای موجود میآموزند و از آنها الگو میسازند.

به همین خاطر هرچه کیفیت دادههای ورودی پایینتر باشد، توانایی هر دو سیستم در درک دقیق الگوهای جدید و چالشهای شناختی کاهش پیدا میکند.

اما نکته تاریکتر پژوهش اینجاست که بعد از آسیبهای وارد شده، وقتی محققان سعی کردند با تزریق دادههای باکیفیتتر اثر این “سوءتغذیه دیجیتال” را جبران کنند، تلاشهایشان ناموفق بود و آسیبهای شناختی همچنان پابرجا باقی ماند.

در گزارشی که دراینباره منتشرشده میخوانیم: «این شکاف نشان میدهد که اثر “پوسیدگی مغز” بهطور عمیقی در مدلها درونی شده و تنظیمات آموزشی فعلی قادر به اصلاح آن نیستند. در آینده باید از روشهای قویتری برای کاهش این اثرات استفاده شود.»

این مطالعه یک بار دیگر خطرهای قرار گرفتن انسان و حتی هوش مصنوعی در معرض آموزش با دادههای بیکیفیت، غیرقابلکنترل و فاقد نظارت علمی را یادآوری میکند و این هشدار زمانی جدیتر میشود که محققان در تحقیقات دیگری هم یادآور شدهاند که وابستگی بیشازحد انسانها به هوش مصنوعی، باعث افت تواناییهای شناختی خود آنها نیز خواهد شد.

منبع: futurism

source